InstagramやFacebookなどのSNSに自撮り写真をアップロードする人が多数います。しかし、このようにWeb上にアップロードされた写真は将来的なAI技術の発展によって、人物のプライバシー情報を入手する材料に使用される可能性が指摘されています。そこで、研究者は「見た目ではわからない」変更を写真に加えて、AIによる顔認識を阻害する技術を開発したとのことです。

- Worried About Privacy for Your Selfies? These Tools Can Help Spoof Facial Recognition AI | Technology News

- How to stop AI from recognizing your face in selfies | MIT Technology Review

- Fawkes

- LowKey: Leveraging Adversarial Attacks to Protect Social Media Users from Facial Recognition | OpenReview

記事作成時点において、AI技術はまだ発展途上であり、deepfakeを使用して、有名人の「ポルノ」や「虚偽の発言を行う様子」の映像が作成される事例はあるものの、その被害が個人に及ぶケースはごく少数です。しかし、研究者はAI技術が発展すると、Web上に投稿された自撮り写真等が勝手に取り込まれ、政府やその他の機関により、その人物の嗜好などプライベートを特定する材料に使用される可能性があると指摘しています。

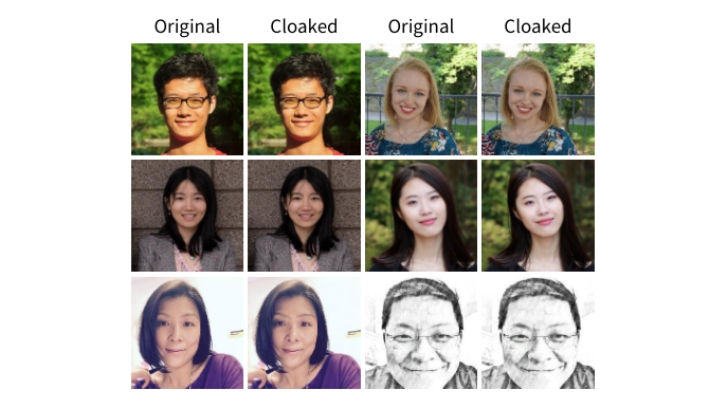

そんな中、AI技術の国際会議「The International Conference on Learning Representations (ICLR)」において、画像変換技術の「Fawkes」と「LowKey」の2つの技術が登場しました。Fawkesはシカゴ大学、LowKeyはメリーランド大学で開発された技術ですが、これらの技術は画像データに「AIが顔認識に必要な部分だけにノイズを加える」ことで、見た目上は元画像と何ら変わりない画像を生成する技術です。

Fawkesにおいては、変換後の顔写真データ50枚を市販の「顔認識ソフトウェア」に取り込む実験を行っており、取り込んだ全ての画像に写っている人物を認識できなかったことが報告されています。ただし、実験時には一部の顔認識ソフトウェアを騙せなくなったこともあり、「顔写真変換技術」と「顔認識AI」の関係はコンピューターウイルスとウイルス対策ソフトの関係にあるような「いたちごっこ」が続いていくと見られています。